Proceso de generación de imágenes

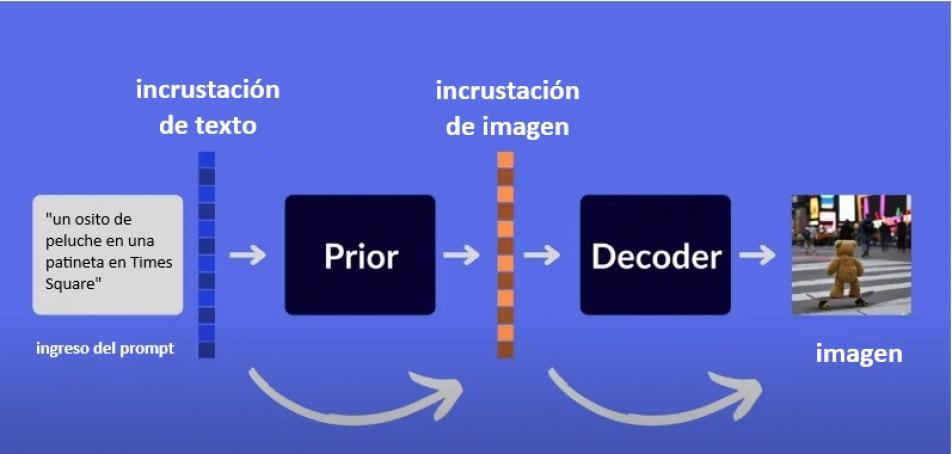

Proceso de Generación de Imágenes en DALL-E

El proceso de generación de imágenes en DALL-E es un recorrido fascinante que combina sofisticadas técnicas de aprendizaje profundo, procesamiento de lenguaje natural y visión por computadora. A continuación, se desglosan los pasos clave involucrados en la generación de imágenes a partir de descripciones textuales utilizando DALL-E.

1. Entrada del Usuario

El proceso comienza con la entrada del usuario, que es una descripción textual de la imagen deseada. Esta descripción puede variar en detalle y especificidad, y puede incluir múltiples elementos que el usuario quiere ver en la imagen.

Ejemplo de entrada:

2. Tokenización del Texto

Transformación del Texto en Tokens:

- La entrada textual se convierte en una secuencia de tokens. Un token puede ser una palabra, parte de una palabra, o incluso un carácter.

- DALL-E utiliza un vocabulario predefinido para dividir la entrada en estos tokens. Este proceso es crucial para que el modelo pueda procesar y entender la entrada de manera efectiva.

3. Representación Multimodal

Emparejamiento de Texto e Imágenes:

- DALL-E está entrenado en un vasto conjunto de datos que contiene pares de descripciones textuales e imágenes correspondientes.

- Durante el entrenamiento, el modelo aprende a asociar patrones en el texto con características visuales específicas en las imágenes. Esto le permite generar imágenes que son coherentes con las descripciones textuales proporcionadas.

4. Mecanismo de Atención y Generación Secuencial

Atención Autoregresiva:

- DALL-E utiliza un mecanismo de atención autoregresiva para generar imágenes de manera secuencial. Esto significa que el modelo genera una parte de la imagen a la vez, basándose en las partes generadas anteriormente y en la descripción textual.

- Este proceso asegura que cada sección de la imagen esté alineada con el contexto de la descripción y las partes previamente generadas.

Cross-Attention:

- La atención cruzada permite al modelo enfocarse en diferentes partes del texto mientras genera diferentes partes de la imagen. Esto mejora la coherencia y la relevancia de la imagen generada con respecto a la descripción textual.

5. Difusión y Refinamiento

Proceso de Difusión:

- En DALL-E 2, el proceso de generación de imágenes se refina utilizando un proceso de difusión. Este proceso comienza con una imagen ruidosa y la refina gradualmente hasta obtener una imagen clara y detallada.

- La difusión se realiza en múltiples etapas, permitiendo al modelo corregir errores y añadir detalles finos en cada etapa.

Generación Autoregresiva:

- La imagen se genera de manera autoregresiva, lo que significa que cada píxel de la imagen se genera uno por uno o en pequeños grupos, basándose en los píxeles generados previamente.

6. Decodificación

Transformación de Tokens en Píxeles:

- Una vez que el modelo ha generado la representación interna de la imagen, esta representación se decodifica en una imagen visible.

- El decodificador toma los tokens generados y los transforma en píxeles de imagen finales, produciendo la imagen que el usuario verá.

7. Evaluación de Coherencia

Uso del Modelo CLIP:

- Para asegurar que la imagen generada sea coherente con la descripción textual, se utiliza el modelo CLIP. CLIP evalúa la relevancia y coherencia de la imagen en comparación con la descripción proporcionada.

- CLIP puede filtrar y seleccionar las mejores imágenes generadas, asegurando que la salida final sea de alta calidad y cumpla con las expectativas del usuario.

8. Salida de la Imagen

Presentación de la Imagen Final:

- La imagen generada se presenta al usuario. Dependiendo de la implementación, el usuario puede tener la opción de ajustar la descripción y regenerar la imagen para obtener diferentes resultados.

Conclusión

El proceso de generación de imágenes en DALL-E es un ejemplo impresionante de cómo las tecnologías de IA pueden combinarse para crear contenido visual a partir de descripciones textuales. Desde la tokenización del texto y la representación multimodal hasta la generación autoregresiva y la evaluación de coherencia con CLIP, cada paso del proceso está diseñado para producir imágenes que son tanto creativas como precisas. Este proceso no solo destaca los avances en el campo de la inteligencia artificial, sino que también abre nuevas posibilidades para la creación de contenido visual y la interacción humano-computadora.